Capítulo 6 Tecnologías de acceso

En este capítulo se presentan algunas de las tecnologías más populares para el despliegue de redes, tanto para la red de acceso como para el núcleo.

Por su relevancia en la sociedad contemporánea, antes de presentar las tecnologías de acceso, iniciamos esta parte con algunas estadísticas sobre la penetración de internet. Esta información nos será de mucha utilidad al analizar la factibilidad de garantizar la cobertura de Internet a toda la población 13.

6.1 Cobertura de Internet

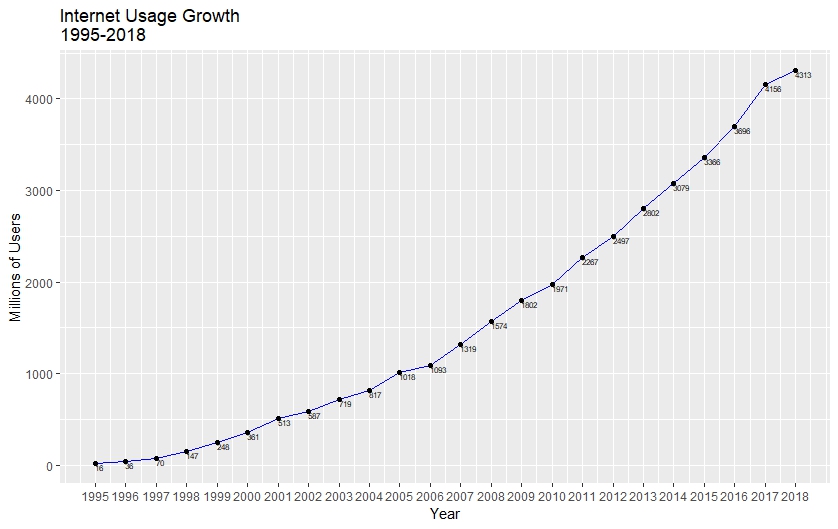

Internet se ha consolidado como una herramienta muy poderosa que ha afectado prácticamente todas las esferas en las que nos desarrollamos como sociedad. Desde su creación, la cobertura de Internet ha crecido muy rápidamente. Como se observa en la figura 6.1, mientras en 1995 el número de usuarios llegaba a 16 millones, lo que representaba un 0.2% de la población mundial total, en diciembre de 2018 el número de usuarios alcanzó los 4,313 millones, aproximadamente 56.5% de la población.

Figura 6.1: Usuarios de Internet por año

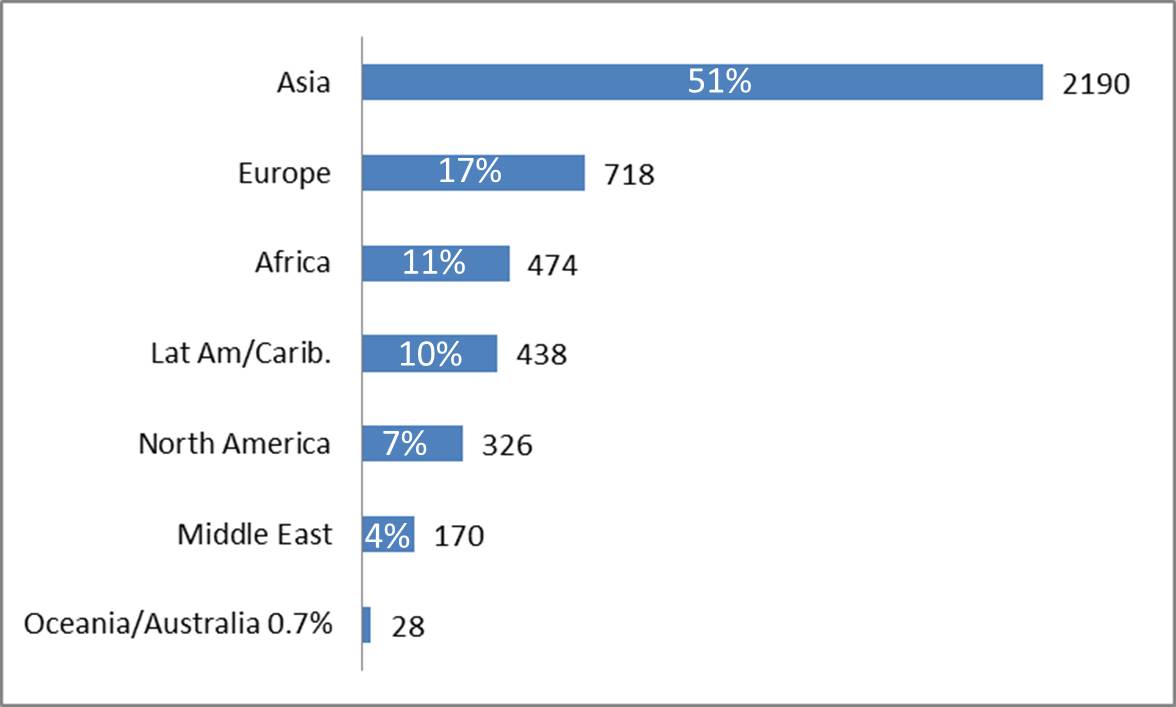

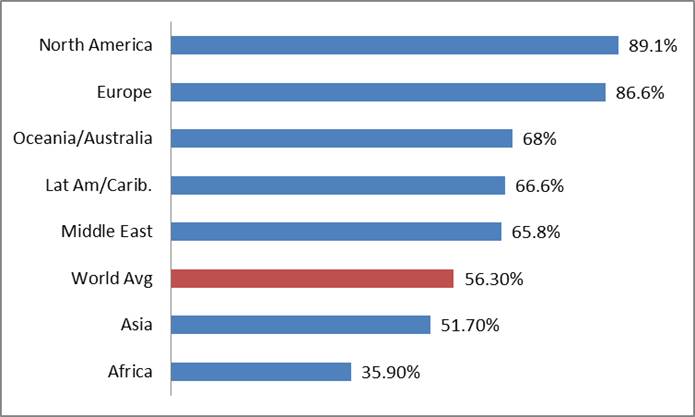

En marzo de 2019 esta cifra alcanzó un total de 4,346 millones los cuales se distribuían geográficamente como se muestra en la figura 6.2. Sin embargo, al analizar la tasa de penetración por región, se observa una enorme desigualdad, la cual puede estar ligada a factores socioeconómicos en términos de acceso a servicios de Internet, pues mientras que en Norteamérica y Europa la penetración rebasa el 85%, tanto Asia (51.7%) como África (35.9%) se encuentran por debajo del promedio global de 56.3%.

Figura 6.2: Usuarios de Internet (en el eje y porcentaje en la barra) y tasa de penetración. Datos a marzo de 2019

6.1.1 Red de acceso

Una red de acceso es la parte de una red de comunicaciones que conecta a los suscriptores con su proveedor de servicios inmediato. Un ejemplo de red de acceso es el par trenzado en el bucle local del operador telefónico, también llamado última milla, que se refiere a la porción de la red que alcanza físicamente las premisas del usuario final.

La infraestructura de las redes de acceso puede llegar a representar entre el 70% y 80% de los recursos físicos para los incumbentes. Las redes de acceso representan un mercado muy competido y con muchos retos para los proveedores, sin embargo, también es un mercado con grandes tendencias de crecimiento. En la década anterior representaba del 16% al 20% de los ingresos globales de las empresas de telecomunicaciones y prácticamente todos los operadores tradicionales.

Se observan dos tendencias en la oferta de los proveedores de acceso a Internet:

Las Redes de Nueva Generación (NGN, Next Generation Network), que ofrecen una amplia gama de servicios de valor agregado en la última milla (independientemente de la tecnología de acceso). Su modelo de negocios está basado en los servicios ofrecidos.

La provisión de acceso, que ofrece infraestructura con muy alta capacidad y un suministro de bajo costo (dumb pipes). Los servicios ofrecidos son de bajo valor agregado, por lo cual su modelo de negocio está basado en la administración de la infraestructura.

Actualmente, la mayoría de los operadores busca migrar hacia las NGN debido a los incentivos que ofrecen, entre los que se encuentran maximizar los ingresos a través de la oferta de nuevos servicios de Internet (correo electrónico, compartir archivos, mensajería instantánea, comunicaciones unificadas, navegación, Web 2.0, etc.) y la conformación de paquetes de triple y cuádruple play (voz, banda ancha y televisión, y acceso móvil).

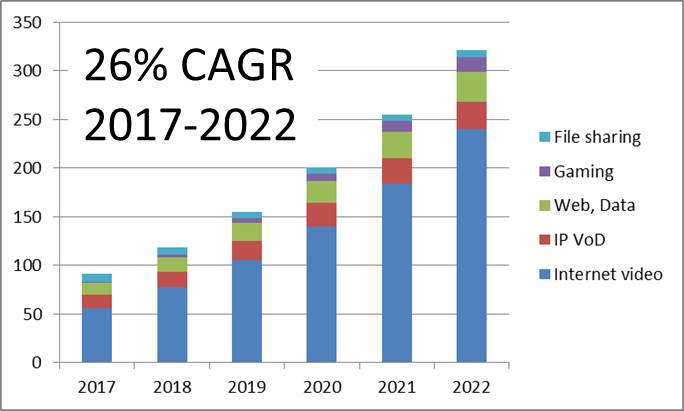

En la figura 6.3 se observa cómo en seis años cambió drásticamente la conformación del tipo de tráfico cursado por los operadores móviles. El tráfico de voz se ha mantenido relativamente estable, pero el de datos ha crecido más que exponencialmente.

Figura 6.3: Tráfico por tipo

La figura 6.4 muestra cómo durante el mismo periodo el crecimiento en los ingresos de los operadoresse ha mantenido más o menos estable (0.3% de aumento). El incremento mayor en ingresos viene de la venta de equipos móviles.

Figura 6.4: Ingresos de los operadores

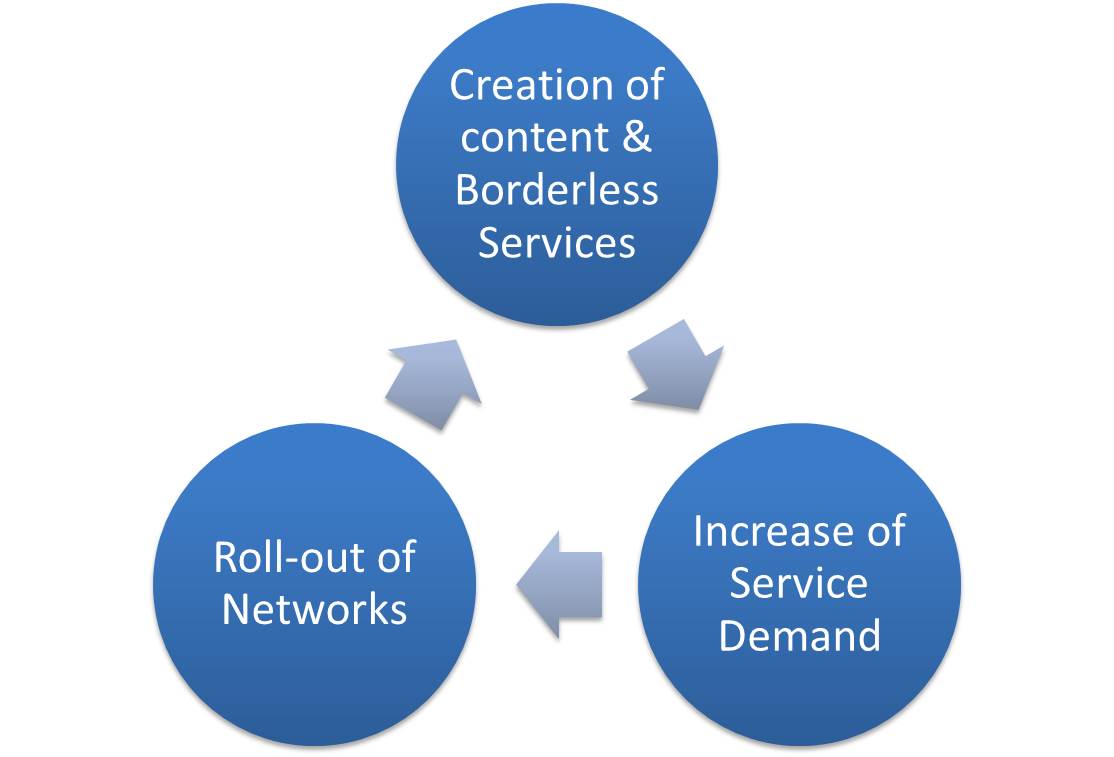

La tendencia hacia mayores servicios a través de Internet explica el crecimiento exponencial en el tráfico cursado. Tan sólo de 2010 a 2017, el volumen de datos se ha incrementado 40 veces. Esto hace necesario un despliegue de infraestructura, creando así el círculo virtuoso de la economía digital (figura 6.5) en el que una mayor oferta de servicios y contenidos produce un aumento en la demanda de los mismos, lo cual hace necesario un nuevo despliegue de redes. Redes más poderas permiten la creación de contenido y servicios de más calidad y con mayores demandas de capacidad... y así sucesivamente.

Figura 6.5: Círculo virtuos de la economía digital

Los mayores obstáculos que enfrenta este círculo, es la demanda excesiva por el crecimiento de flujos de video, como lo muestran los datos de Cisco VNI presentados en la figura 6.4. En el 2017, el 59% del tráfico de datos móviles era de video y se estima que para 2022 será del 79%.

Figura 6.6: Tráfico de datos móviles estimado (en 2017) por tipo

6.1.2 Contexto de Internet y servicios de Banda Ancha en México

En los últimos años la cantidad de usuarios de Internet en México ha crecido considerablemente, alcanzando 71.3 millones en el 2017, lo que representa más del doble de los usuarios en 2010, como se muestra en la figura 6.7.

Figura 6.7: Usuarios de Internet en México

Sin embargo, recordemos que es necesario considerar el aumento en la oferta de este servicio no sólo en términos de cantidad de usuarios, sino la tasa a la que se da esta penetración con relación a otras economías, y el porcentaje de penetración dentro de las distintas regiones del país14.

Comparando la penetración de Internet en México con otras economías, hacia el año 2018 la figura 6.8 muestra que en 2018, la cobertura en México se encuentra por encima del promedio en Latinoamérica con un 65% de penetración, aunque un poco lejos de Argentina, Chile y Costa Rica.

Figura 6.8: Penetración de Internet en América Latina (2018)

Si ahora vemos la situación de México con respecto a la OCDE, el panorama cambia drásticamente pues el país se encuentra en las últimas posiciones en servicios de banda ancha tanto fija (penúltimo lugar, figura 6.9) como móvil (ante penúltimo lugar, figura 6.10). Cabe destacar que en el servicio móvil las suscripciones ofrecidas son prácticamente en su totalidad de voz y datos, en vez de ofrecer también suscripciones de sólo datos, como prácticmaente todos los países de la OCDE.

Figura 6.9: Suscripciones de banda ancha fija (OCDE)

Figura 6.10: **Suscripciones de banda ancha móvil (OCDE)*

6.1.3 Banda Ancha

Hemos estado hablando de banda ancha. Se trata de un término particularmente elusivo al tratar de definirla. La banda ancha puede verse como un conjunto de tecnologías de red avanzadas o como el motor de una radical y gran transformación que revitaliza la entrega de los servicios existentes y da pie a la aparición de nuevos e innovadores servicios. La banda ancha se ha convertido en una infraestructura fundamental que determina la competitividad nacional de los países en la economía digital mundial.

En términos técnicos, la banda ancha ha tratado de definirse en función de las velocidades de transmisión mínimas, del tipo de tecnología (por ejemplo, IMT-Avanzadas móviles o las llamadas tecnologías 4G), y de una serie de conceptos funcionales entre los que se encuentran conexión permanente y alta capacidad.

El debate para tratar de definirla no se ha detenido, y a manera de conciliación, suele definirse de manera informal e imprecisa, a la banda ancha como las tecnologías que permiten la entrega fiable con con calidad de servicios convergentes de voz, datos y video.

La banda ancha ha demostrado ser un elemento esencial para el desarrollo económico, a tal punto que en 2010 Finlandia la declaró como un derecho ciudadano, al mismo nivel que la alimentación, la salud y la educación, pues promueve la creación de nuevos servicios digitales, mayor eficiencia y productividad, estimula la competitividad, habilita ventajas de la globalización y promueve el acceso a redes de innovación. En México, si bien no se especifica con servicios de banda ancha, el acceso a Internet se convirtió en un derecho ciudadano plasmado en la Constitución, con la Reforma en Telecomunicaciones de 2013.

La figura 6.11 muesra el nivel de penetración de banda ancha fija en los países de la OCDE en 2018, así como su ingreso per cápita en dólares PPP15. Hay una clara relación entre penetración banda ancha y nivel de riqueza, pero es difícil demostrar cuál es la dirección de la causalidad.

Figura 6.11: Penetración de banda ancha vs GDP (OCDE)

Prácticamente todos los países desarrollados y en vías de desarrollo disponen de banda ancha. Hoy en día la principal preocupación es evitar la creación de brechas digitales en términos de velocidad o calidad de acceso. Grupos multipartitas como la Comisión de la Banda Ancha para el Desarrollo Digital de las Naciones Unidas están fomentando que todos los países en sus planes de desarrollo den prioridad al desarrollo de redes fijas y móviles de alta velocidad a fin de cimentar sus previsiones de crecimiento económico a largo plazo y de competitividad en la era de la información.

Parece que en México todavía hay mucho por hacer en banda ancha fija pues tenemos un gran rezago en términos de velocidades y de suscripciones, como lo muestra la figura 6.12. Podemos ver que el país apenas llega a un nivel de alrededor de 15 suscripciones por cada 100 habitantes, y de éstas, la gran mayoría son de una velocidad de entre 10 y 25 Mbps. Esto se encuentra muy lejos de objetivos como los fijados en Europa, que establecen una penetración del 100% al menos a 30 Mbps y del 50% al menos a 100 Mbps y hacia 2018 se encuentran cerca de ser alcanzados, según el reporte DESI (Digital Economy and Society Index) de la Comisión Europea de 2018.

Figura 6.12: Banda ancha fija. Penetración y velocidades de acceso (OCDE)

Con relación a los costos a usuarios finales, México presenta un rango de precios muy grande en comparación con otros países de la OCDE, con costos que van de aproximadamente 30 dólares PPP para usuarios de bajo nivel (20 GB/mes, 0.250 Mbps) a los 65 dólares PPP para usuarios de alto nivel (200 GB/mes, 25 Mbps). Este comportamiento se debe principalmente a que si bien los precios a usuarios de bajo nivel se encuentran en el promedio de la OCDE, cuando vemos los precios ofertados a usuarios de alto nivel, México tiene los niveles más elevados como se observa en la figura 6.13. Aún con precios ajustados PPP, el acceso a banda ancha fija sigue siendo muy costoso para los deciles más bajos de la población nacional; justamente los grupos de población que se encuentran fuera de los servicios de Internet.

Figura 6.13: Comparativo de costos (USD, PPP) en países de la OCDE a junio de 2017. (a) Costos usuarios de bajo nivel; (b) Cosos a usuarios de alto nivel; (c) Rangos de costos (USD, PPP)

6.2 Tecnologías de acceso

Las expectativas de tráfico para los próximos años alcanzan niveles difíciles de asimilar. Se estima que para 2022, el tráfico IP anual será de 4.8 zettabytes16, lo cual, para dimensionar la magnitud, es igual a 11 veces el tráfico generado en 2012. 82% de ese tráfico será de aplicaciones de video y 71% será por medio de tecnologías inalámbricas.

Para cumplir con estas expectativas, las tecnologías de acceso deben estar en constante evolución de manera que la provisión de contenidos y servicios innovadores.

Las tecnologías de acceso pueden clasificarse en dos categorías:

Tecnologías por línea, como lo son:

xDSL

Cable Módem

PLC

Fibra + cable

Tecnologías inalámbricas, tales como:

WiFi

WiMax

Celular

Satélite, HAP

Radio cognitivo

6.2.1 Tecnologías de acceso cableadas

xDSL

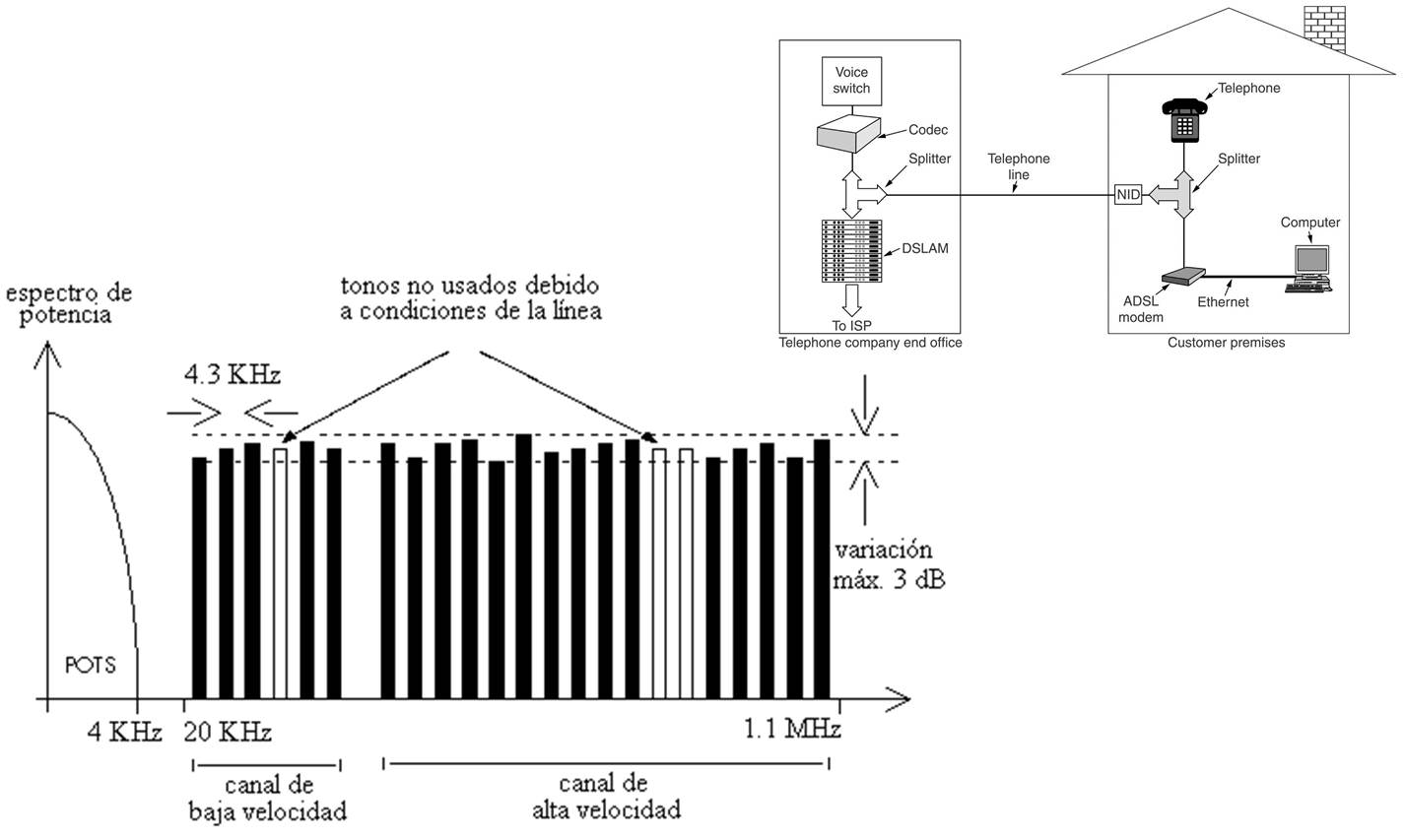

xDSL (Digital Subscriber Line, Línea de Abonado Digital) es una familia de tecnologías que proporcionan acceso a Internet mediante la transmisión de datos a través del par trenzado de hilos de cobre convencionales de la red telefónica convencional. Emplea los rangos de frecuencia que no son utilizados para el transporte de voz, maximizando así el ancho de banda de la red de acceso (llamada la red de última milla) de los operadores telefónicos.

En el equipo que se coloca en las instalaciones del usuario17 hay un filtro (splitter) el canal de frecuencias bajas, dedicado a los servicios de voz, del resto de frecuencias, dedicadas a la transferencia de datos.

De forma similar, en la central telefónica las tarjetas DSLAM (Digital Subscriber Line Access Multiplexer) separan las frecuencias bajas (que dirigen a la red telefónica) de las altas, donde viaja el tráfico que debe ser dirigido a Internet, como se muestra en la figura 6.11, que se refiere al tecnología ADSL(Asymmetric DSL), que es la tecnología xDSL más popular.

Figura 6.14: Tecnología ADSL

ADSL se denomina “asimétrica” porque las capacidades de descarga o de bajada (de la red hacia el usuario) y de subida (en sentido inverso) de datos no coinciden. La tecnología ADSL está diseñada para que la capacidad de bajada sea mayor que la de subida, ideal para servicios de red “cliente-servidor” en los que el cliente (el usuario) solicita un servicio, por ejemplo la descarga de una página web y el servidor, por ejemplo el servidor Web, la envía. La consulta requiere de mucho menos capacidad que la transferencia del contenido.

En ADSL, el ancho de banda dedicado a la transferencia de datos se divide en hasta 256 subportadoras (las espigas rectangulares de la figura). Típicamente cada una es un canal de 4 kHz con modulación QAM. En principio, cada una puede transportar hasta 60 kbps (4000 baudios, con 15 bits por baudio). Si una subportadora tiene mucho ruido, ésta deja de utilizarse (las espigas blancas de la figura), lo que reduce la velocidad de transmisión del medio.

Como se ha mencionado, ADSL es la más popular de las tecnologías xDSL, pero existen muchas otras. La siguiente tabla muestra las características de velocidad teóricas de algunas de las más populares.

| ADSL | HDSL | ADSL2+ | VDSL | |

|---|---|---|---|---|

| Asymmetric | High Bit Rate | Asymmetric | Very High Speed | |

| DSL | DSL | DSL | DSL | |

| De la red | 256 kbps | 1,168 kbps | 25 Mbps | 13, 42, 200 Mbps |

| al usuario | ||||

| Del usuario | 64 kbps | Simétrico | 1 Mbps | 1, 5, 6 Mbps |

| a la red | 1.5 Mbps | |||

| Distancia | 2.5 km | Hasta 4 km | 1 km | 52 Mbps 750 m |

Dentro de las ventajas de esta tecnología se encuentran la recuperación del costo de despliegue del par de abonado, la retención del ARPU (Average Revenue per User, ingreso medio por suscriptor), su bajo costo y su ubicuidad. Además, ofrece la posibilidad de hablar por teléfono al mismo tiempo que se navega por Internet.

Un gran inconveniente de ADSL es que la velocidad del servicio está limitada por varios factores, como la calidad del cable y la distancia hasta la central telefónica, así como por el número de pares que viajan juntos en el ducto. Además, en muchos países el marco regulatorio puede limitar la desagregación del par18, lo que representa una barrera de entrada a la competencia.

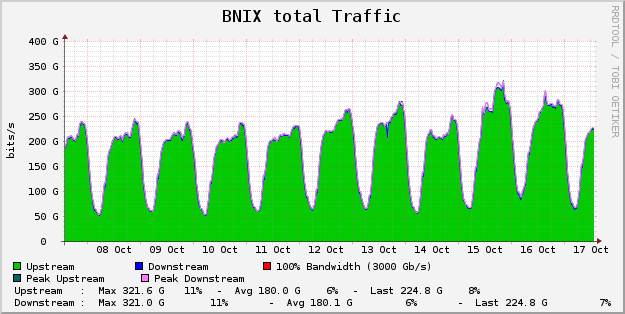

Otro inconveniente de ADSL es que los enlaces asimétricos pueden ser inadecuados para las características de los usuarios contemporáneos, como lo muestra la figura @ref[fig:upstream) obtenida de tráfico en un servidor de Twitter.

En un entorno más familiar, jamás se debería poner un servidor local a través de un enlace asimétrico.

Figura 6.15: Tráfico simétrico en Internet

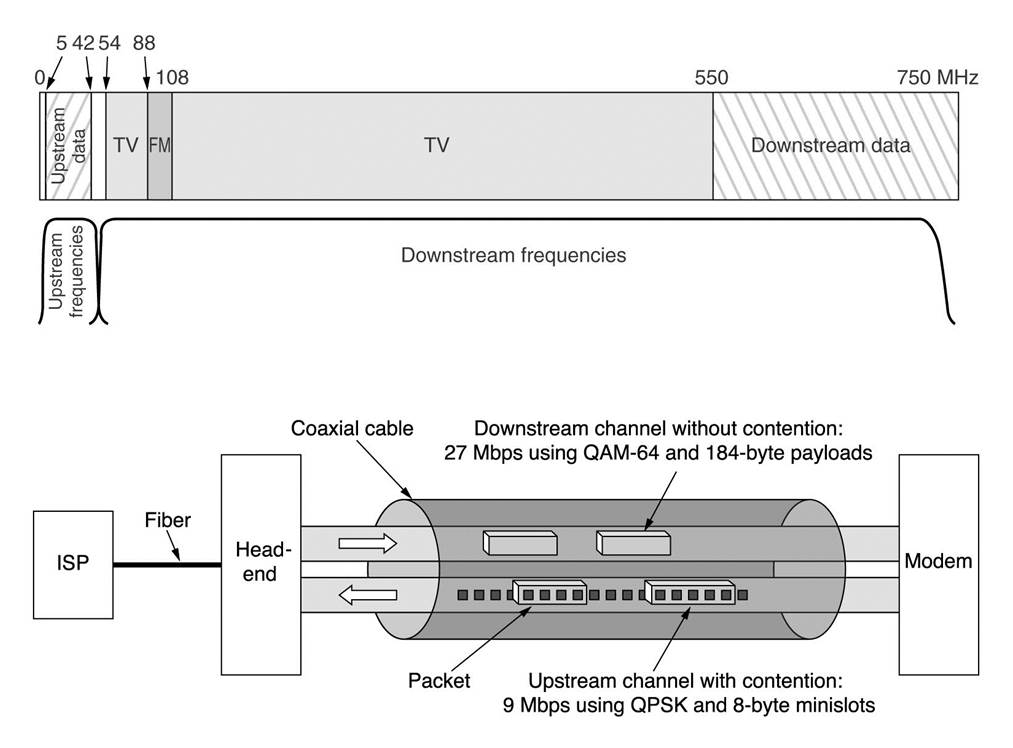

Cable módem

El cable módem es un tipo especial de módem diseñado para modular y demodular la señal de datos sobre una infraestructura de televisión por cable. Se utiliza principalmente para distribuir el acceso a Internet de banda ancha, aprovechando el ancho de banda que no se utiliza en la red de televisión por cable.

(#fig:cable_modem)Cable módem

Esta tecnología presenta las ventajas de que el cable es de mayor calidad que el par trenzado. Bajo la norma DOCSIS 3.1, se pueden alcanzar velocidades de 10 Gbps en el canal descendente y 1 Gbps en el ascendente, en condiciones ideales.

La principal desventaja es que los abonados de un mismo vecindario comparten el ancho de banda proporcionado por una única línea de cable coaxial. Por lo tanto, la velocidad de conexión puede variar dependiendo de cuántos equipos están utilizando el servicio al mismo tiempo.

Otras desventajas son las inversiones necesarias para modificar la infraestructura para servicios digitales bidireccionales, y que el unbundling (la desagregación de servicios) puede ser legalmente complicado pues frecuentemente estas redes se despliegan con los propios recursos de los operadores (lo que no necesariamente fue cierto al desplegar las redes telefónicas a principios del siglo XX).

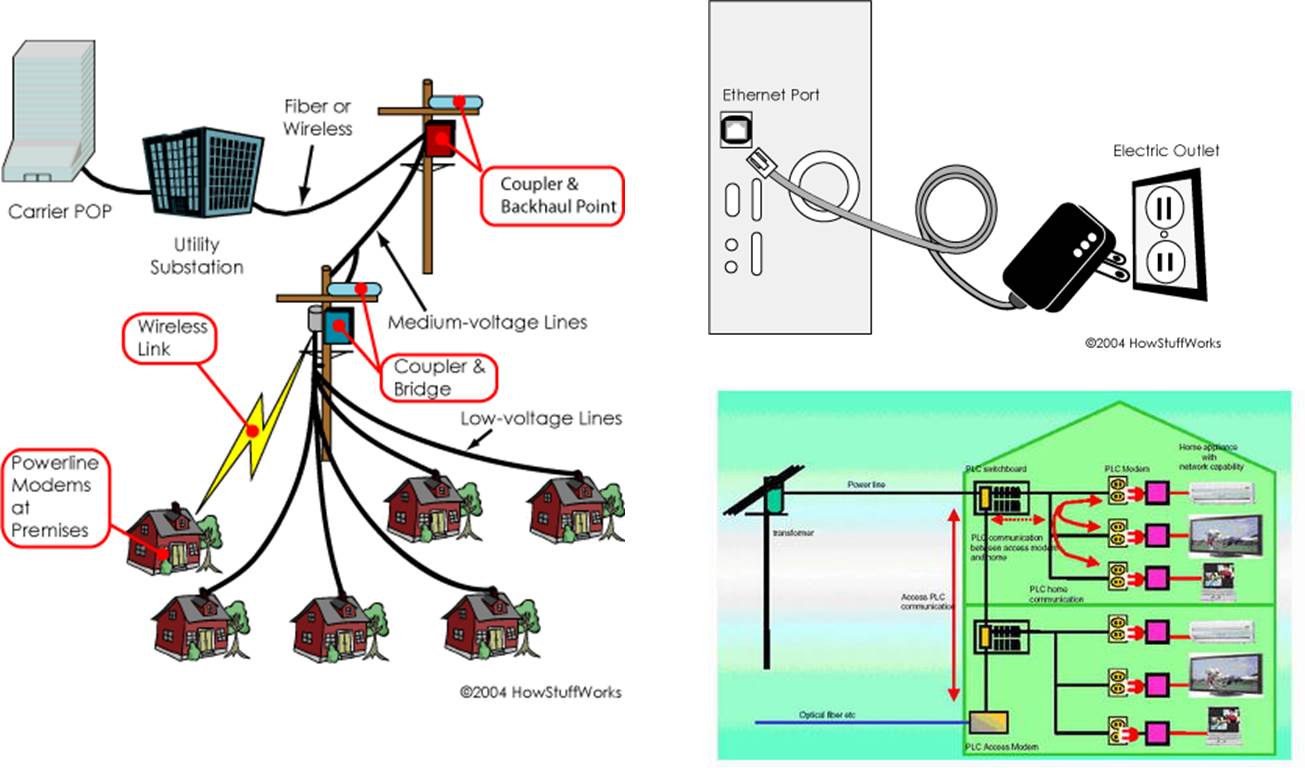

PLC (Power Line Communications)

Se refiere a un conjunto de tecnologías para ofrecer acceso a través de los cables de energía eléctrica. El servicio se ofrece a través de la red eléctrica de baja tensión (110-380V) por medio de unidades acondicionadoras que filtran y separan las señales eléctrica y de datos.

Como red de acceso, esta tecnología, también llamada BPL (Broadband over Power Lines), prometía ser una alternativa a las redes de DSL y de cable módem aprovechando que la cobertura de la red eléctrica es mayor que la de las redes telefónicas y de cable.

Desgraciadamente, las señales de datos, al ser transmitidas en un medio no blindado, pueden causar interferencia a otros sistemas de radio-comunicaciones, lo que ha limitado severamente su despliegue en varios países, aunque en los últimos años se observa un interés creciente en aplicaciones emergentes de Internet de las cosas (IoT) que no requieren de transferencias de datos a alta velocidad.

En cambio, HomePlug (HP) es una variante utilizada para desplegar redes locales dentro de los hogares ha logrado una gran aceptación en el mercado. Su última versión, AV2 puede alcanzar hasta 500 Mbps, más que suficiente para transportar flujos de video de alta definición dentro de los hogares.

HomePlug es desarrollada por CEPCA (Consumer Electronics Powerline Communications Alliance). Por su parte, ITU desarrolla un nuevo estándar G.9960 conocido como G.hn. Pretende utilizar cualquier medio de cobre en el hogar (cable telefóncio, cable coaxial de TV y las líneas eléctricas de corriente alterna) para transmitir datos a tasas de hasta 1 Gbps.

Figura 6.16: Esquema PLC

Redes de fibra e híbridas

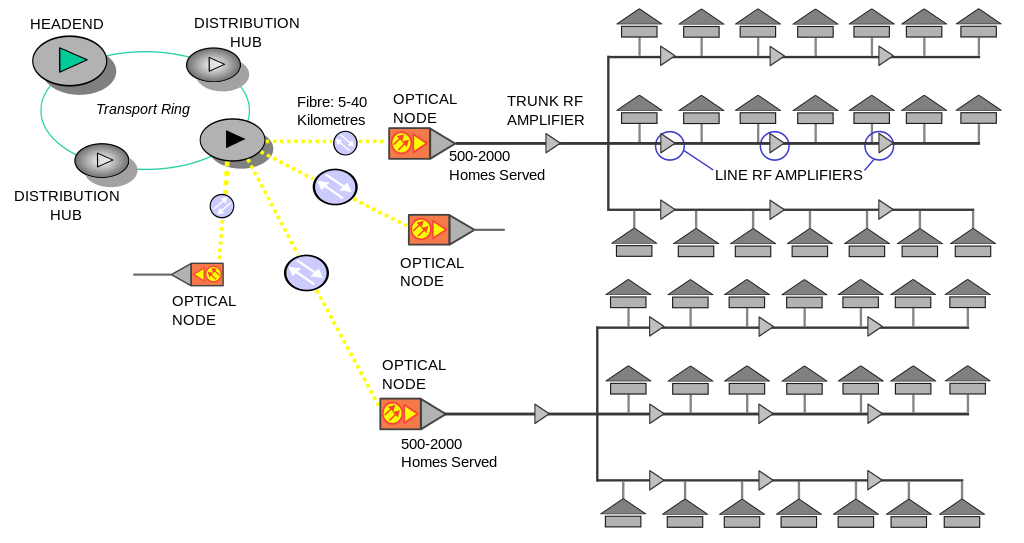

Una red híbrida HFC (Hybrid Fiber Copper) incorpora fibra óptica y cable coaxial para crear una red de banda ancha. Esta tecnología se implementa típicamente como evolución de las redes de televisión por cable para soportar la demanda creciente dde transferencia de datos y más canales de video de alta definición.

Este tipo de red busca aprovechar las ventajas de cada tecnología que la conforman. Los hilos de fibra óptica permiten la cobertura de largas distancias con un mínimo de amplificación y regeneración de la señal, sin embargo, debido al costo y dimensiones de los multiplexores y demultiplexores ópticos, no se suele conectar directamente a los nodos de clientes; la fibra es conectada a un gateway el cual contiene al menos un transformador óptico que permite la transición de la señal a la red de cable coaxial. El cable coaxial permite que la señal llegue a los equipos terminales.

Las limitaciones de estos sistemas son que la señal puede necesitar ser amplificada y el sistema puede ser susceptible a interferencias externas.

(#fig:red_HFC)Diagrama de una red HFC

Redes FTTx

La fibra hasta el punto x (Fiber To The x) se refiere a un conjunto de tecnologías de telecomunicaciones que se basan en la utilización de hilos de fibra óptica y sistemas de distribución ópticos para ofrecer servicios avanzados a hogares y negocios. Este tipo de tecnología presenta características muy deseables, como:

Alta inmunidad a la interferencia electromagnética

Enorme ancho de banda para grandes distancias

El costo de la fibra es del mismo orden que el cobre, aunque los despliegues, interfaces y OAM (Operación, Administración y Mantenimiento) son más costosos

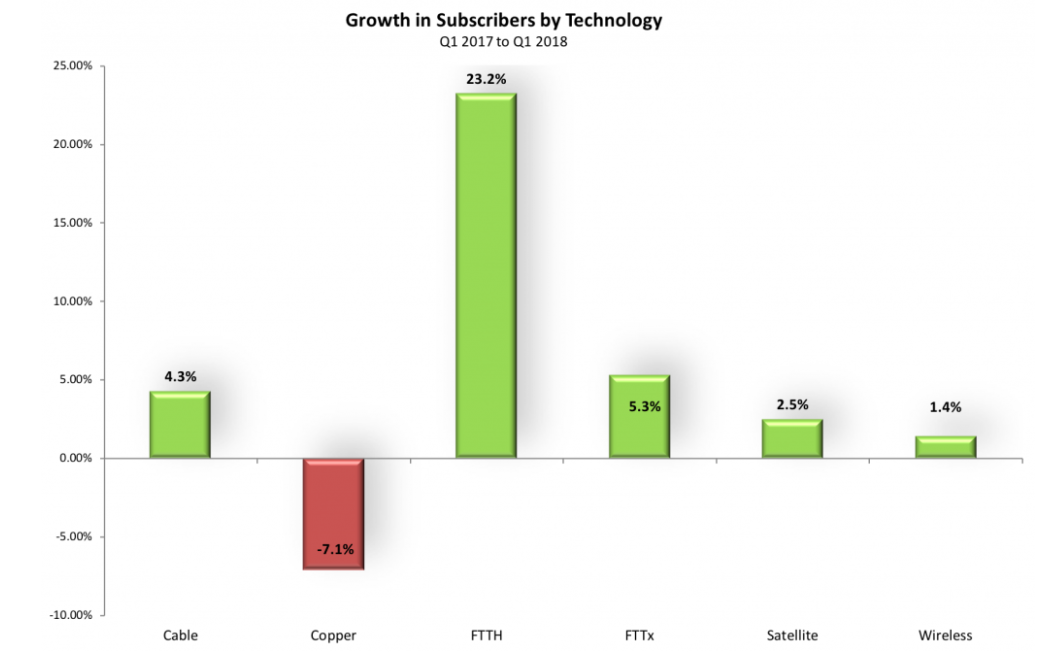

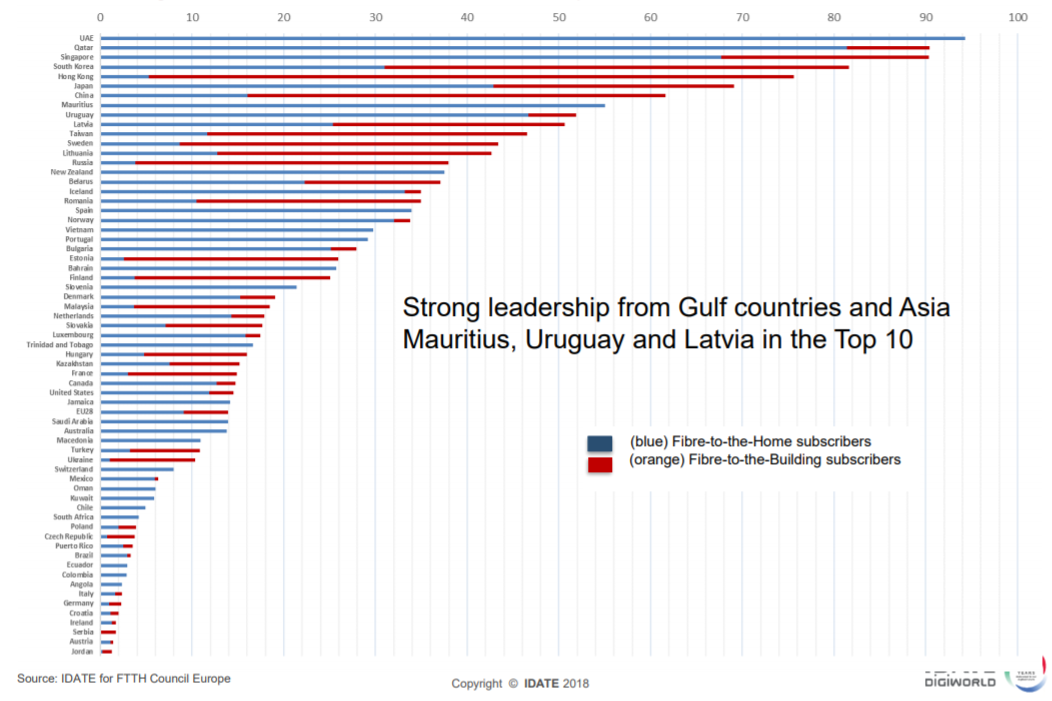

Debido a estas ventajas, los despliegues de fibra han crecido enormemente en los últimos años. La figura 6.17 muestra que las tecnologías que mayor crecimeinto tuvieron de 2017 a 2018 son FTTH (23.2%) y otros despliegues de fibra (5.3%), esto en detrimento, sobre todo, de los despliegues en par trenzado, que tuvieron una caída de -7.1%.

Figura 6.17: Crecimiento de suscriptores por tecnología

Para finales de 2018, la región dominante en despliegues de fibra óptica son los países asiáticos donde la cobertura se acerca al 90% de hogares y edificios (figura 6.18).

Figura 6.18: Número total de suscriptores a FTTx en el mundo

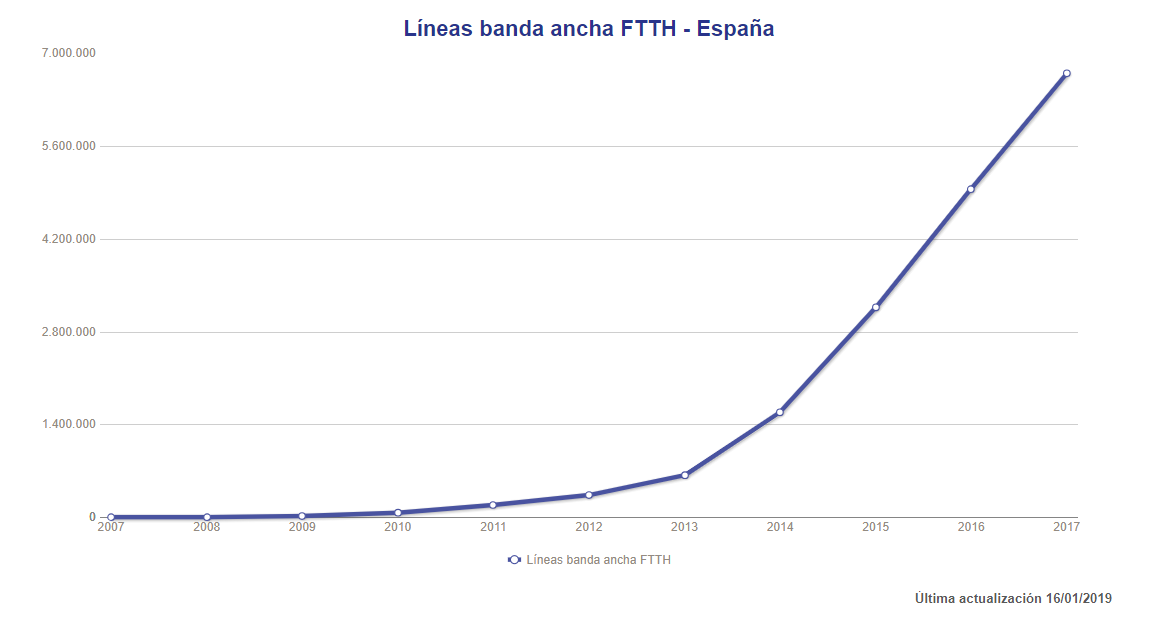

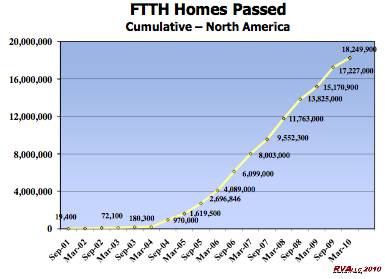

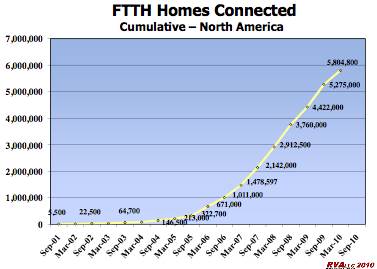

Este fenómeno está ocurriendo en casi todos los países desarrollados y la mayoría ya han entrado a la etapa de crecimiento acelerado de las características curvas “S” de absorción tecnológica (que retomaremos en el capítulo 7). La figura 6.19 muestra el crecimiento de suscriptores en España de 2007 a 2017 y la figura 6.20 la de Estados Unidos de 2001 a 2010. Llama la atención tanto el parecido de las curvas como los números absolutos en ambos países.

Figura 6.19: Penetración de FTTH en España

Figura 6.20: Penetración FTTH en EUA. (a) Hogares visitados; (b) Hogares antendidos

Cabe mencionar que los Estados Unidos se vieron beneficiados por agresivas políticas públicas como el USA Recovery and Reinvestment Act, que destinó más de 7 mil millones de dólares para fomentar el despliegue de fibra óptica durante la administración de Barak Obama. Este tipo de iniciativas permitió que una gran cantidad de hogares tuvieran la posibilidad de contratar accesos en fibra aunque menos de la tercera parte lo haya hecho, como se muestra en la figura 6.20.

6.3 Tecnologías de acceso inalámbricas

Las tecnologías inalámbricas utilizan una señal radioeléctrica (una portadora) para transmitir información modificando algunas de sus propiedades (frecuencia, fase o amplitud). Como redes de acceso a Internet, las tecnologías inalámbricastienen la gran ventaja de que es mucho más rápido y económico levantar una torre y colocar antenas de comunicaciones, que hacer tendidos de cable en postes o ductos en ciudades y en zonas rurales.

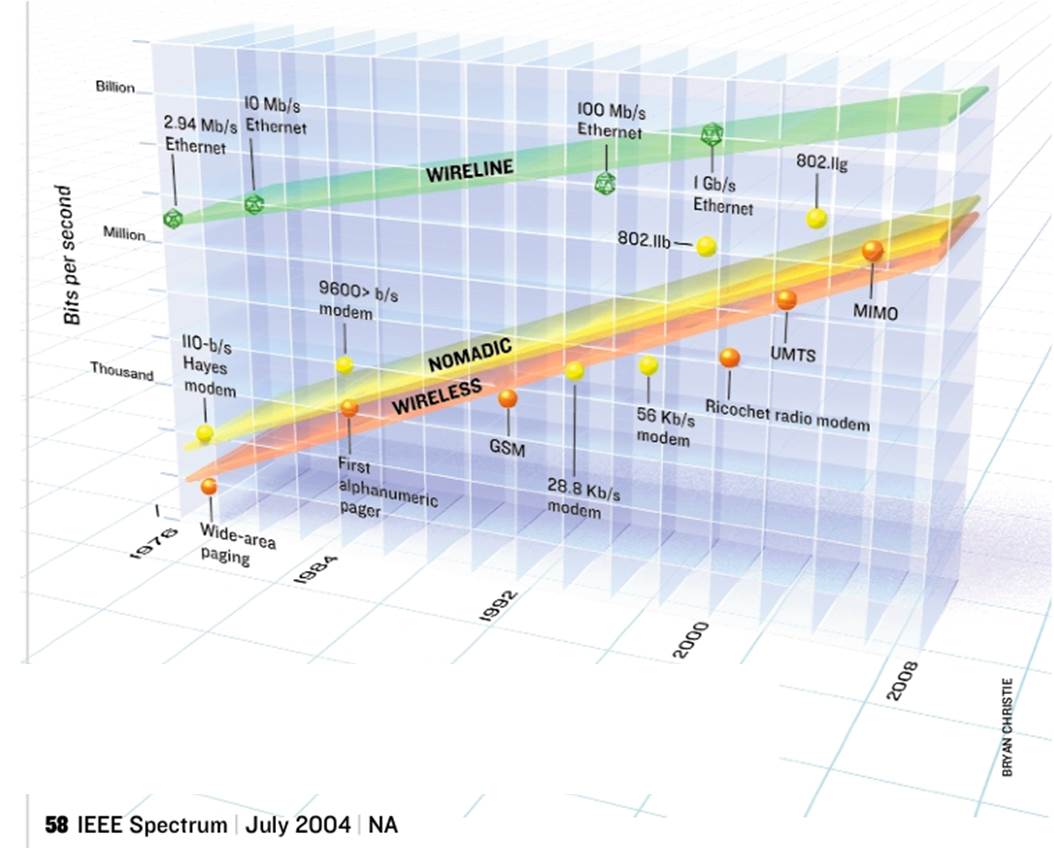

Esta flexibilidad ayuda a explicar porqué las tecnologías inalámbricas han tenido un avance sorprendente en los últimos años. De hecho, si se extendieran las curvas mostradas en la figura 6.21, las velocidades ofrecidas por las tecnologías cableadas e inalámbricas convergerían hacia el año 2030.

Figura 6.21: Velocidades de tecnologías de acceso

La realidad es que es difícil creer que esto sucederá, pues las tecnologías inalámbricas se enfrentan a muchos retos, como la relativa escasez de espectro radioeléctrico y la gran variabilidad de las capacidades de estas tecnologías, en función de la frecuencia que utilicen para su transmisión.

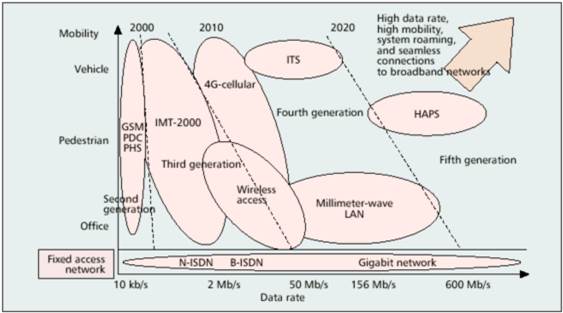

Por ello, es claro que no se tendrá “una gran tecnología dominante” sino una serie de soluciones tecnológicas que atienden diferentes nichos con distintas necesidades. La figura 6.22 muestra una panorámica de las tendencias tecnológicas en función de dos criterios: movilidad y velocidad de transmisión.

Figura 6.22: Evolución de tecnologías inalámbricas

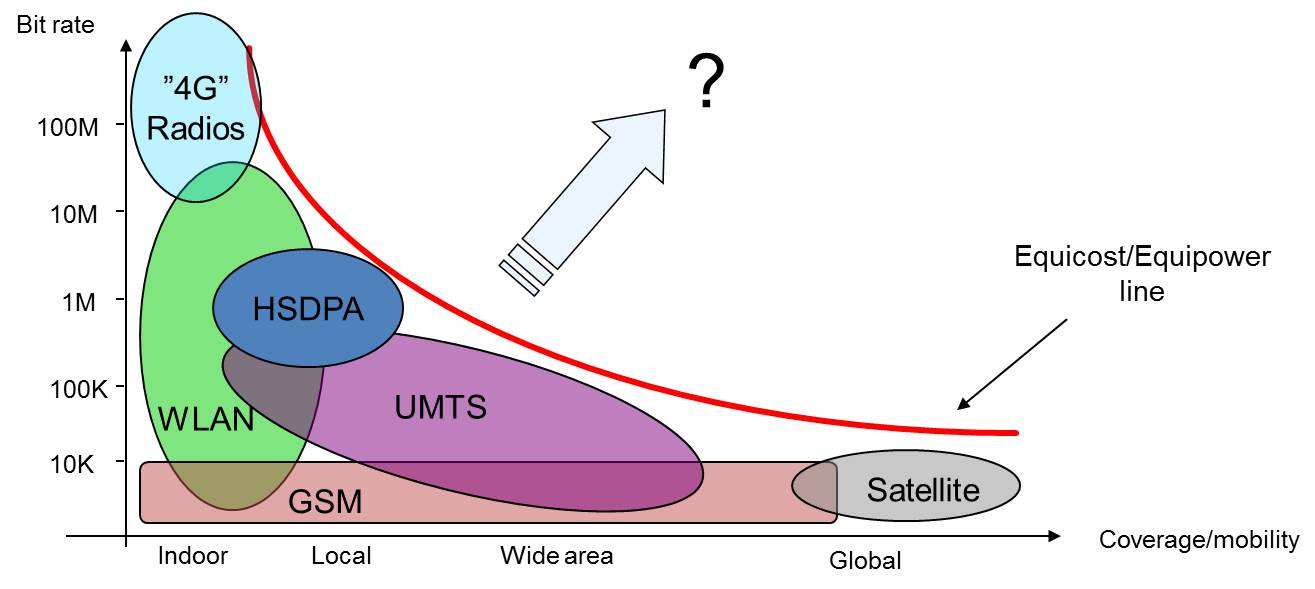

Tratando de presentar de manera sencilla conceptos que técnicamente son relativamente complejos, siempre encontramos un compromiso entre la cobertura (qué tan lejos puede propagarse) y la capacidad (qué tasa de transferencia ofrece) de una red. Por ejemplo, en la figura 6.23 ubicamos algunas de las tecnologías inalámbricas más populares en función de su tasa de transmisión y su cobertura.

Figura 6.23: Sistemas inalámbricos en cobertura vs capacidad

La curva envolvente de la figura anterior es llamada Equi-cost/Equi-power porque un elemento clave del alcance y de la calidad de la señal (y por tanto, de la tasa de transmisión), es la potencia de transmisión la cual puede estar limitada por el costo (a mayor potencia, mayor costo) o por aspectos regulatorios para evitar daños a la salud o interferencias a otros servicios.

Dos factores que afectan la propagación de una señal radioeléctrica son la frecuencia de la señal y la distancia entre el emisor y el receptor. La fórmula simplificada de Friis (figura 6.24) muestra cómo es esta relación en términos de la potencia recibida: Es directamente proporcional a la potencia transmitida e inversamente proporcional al cuadrado de la distancia y de la frecuencia.

\[P_{rx} = P_{tx}\{\frac{1}{f\times d}\}^2\]

Figura 6.24: Fórmula simpificada de Friis

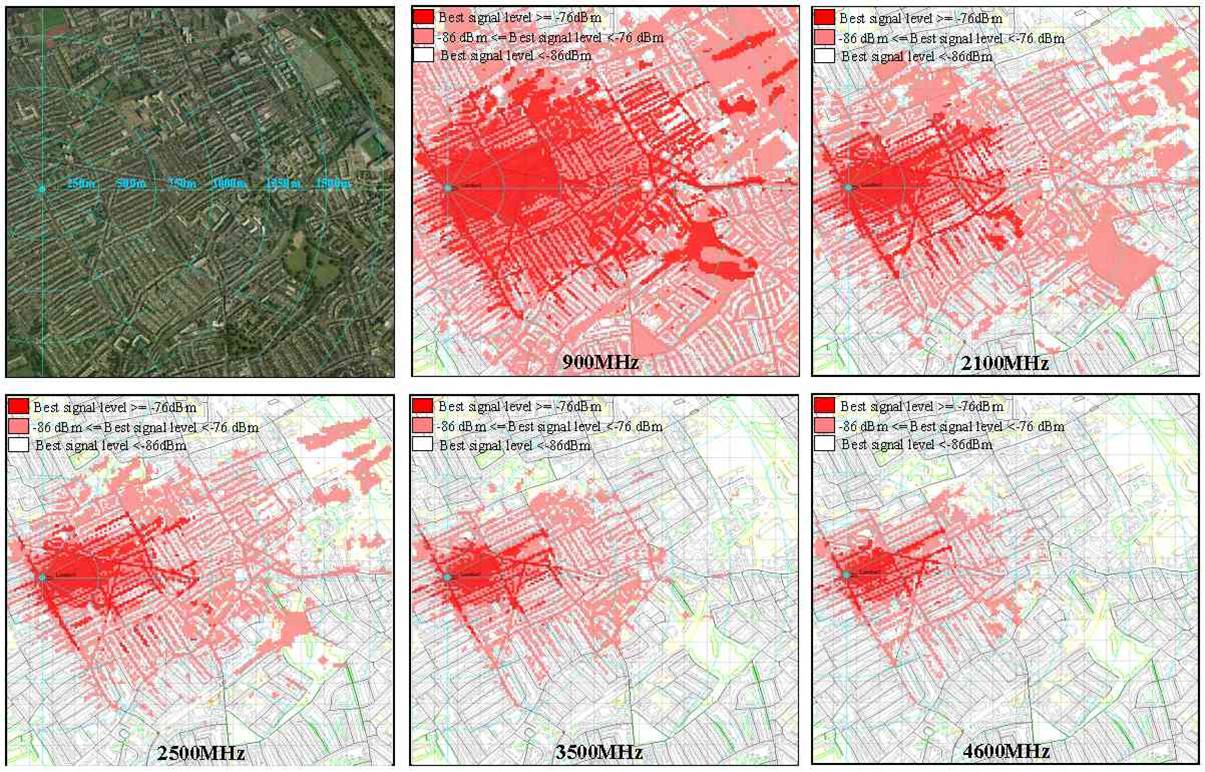

En las frecuencias más altas, la longitud de onda es del orden de las moléculas de agua en la atmósfera y la energía de la señal es parcialmente absorbida pór éstas (y por otros objetos); en cambio, portadoras en frecuencias más bajas, como las bandas de 600 y 700 MHz, hasta pueden atravesar paredes sin sufrir una atenuación tan alta. En la figura 6.25 se muestra cómo este efecto tiene un impacto en la cobertura de una radio base transmitiendo con la misma potencia en distintas frecuencias, en una zona urbana. Mientras que a 900 MHz se cubre con una calidad aceptable un área con un radio de 1.5 km, a 3.5 GHz esta cae a menos de 500 metros.

Figura 6.25: Efecto de la frecuencia en el área cubierta por una radio base

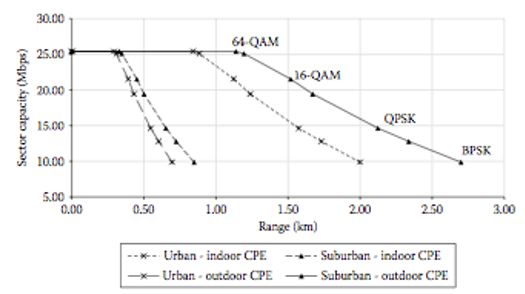

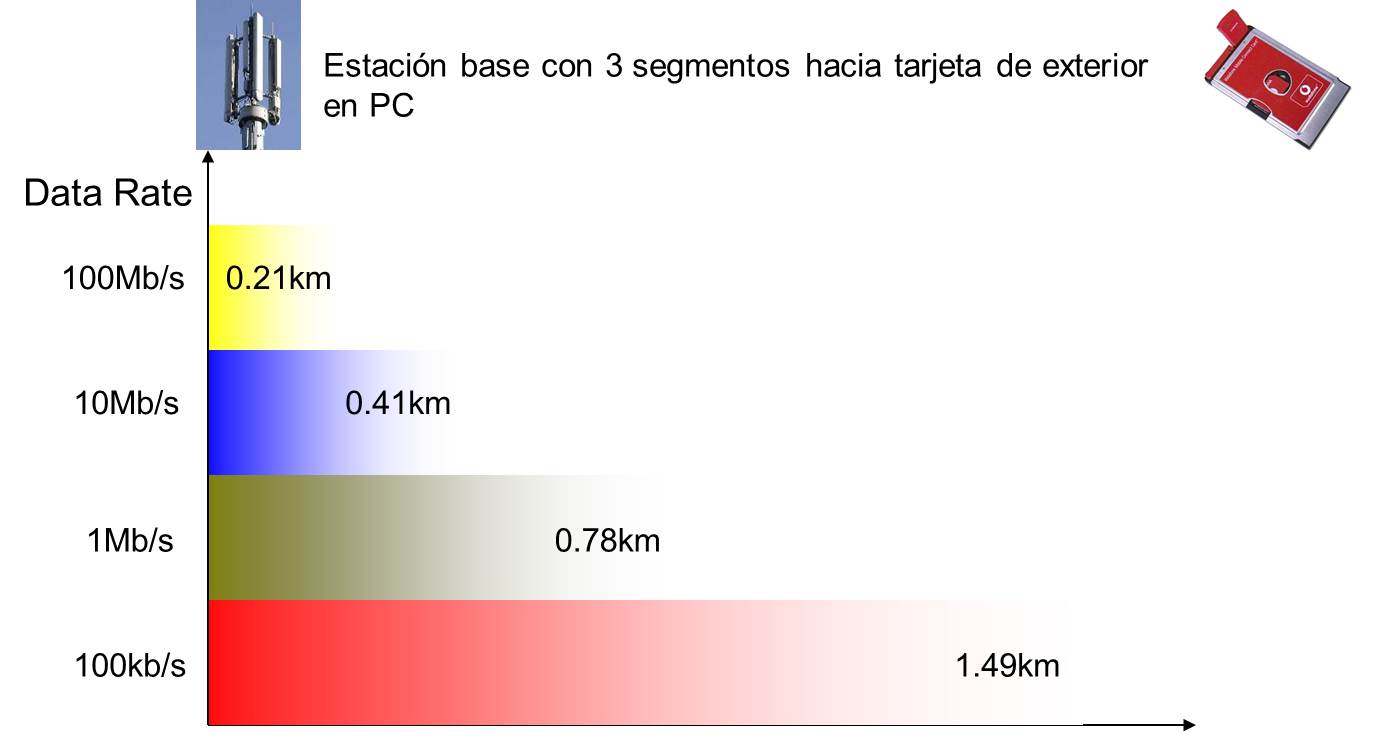

Como la potencia de recepción disminuye con la distancia, la relación señal a ruido (SNR, Signal-Noise-Ratio) disminuye drásticamente. Por ello, informalmente, la energía que debe tener un bit en un símbolo debe ser mayor; más formalmente, la “eficiencia espectral” disminuye con la distancia, como se muestra en la figura 6.26. La figura muestra cómo debe utilizarse un modulador con menor densidad conforme aumenta la distancia. Las distintas curvas son para diferentes tipos de receptor en las instalaciones del usuario (CPE, Customer Premises Equipment).

Figura 6.26: Densidad del modulador en función de la distancia

Figura 6.27: Tasa de transmisión vs distancia

El hecho de que se utilice un modulador con menor eficiencia espectral es lo que explica que la tasa de transmisión disminuya conforme nos alejamos del AP en las redes WiFi o de la radio base en las redes celulares, como se muestra en la figura 6.27.

Resumiendo, la tasa efectiva estará afectada por la potencia del transmisor, la distancia del receptor y la frecuencia de la portadora. Es claro que también se verá afectada por objetos que obstruyan la trayectoria entre transmisor y receptor, la ganancia de la antena del receptor (que depende de su tamaño, entre otros factores) y, de manera muy importante, de la cantidad de espectro (“el tamaño del bloque”) que el regulador del espectro radioeléctrico en un país (en nuestro caso, el Instituto Federal de Telecomunicaciones), otorgue para el servicio de comunicación inalámbrica de que se trate.

La siguiente tabla muestra características de equipos receptores CPE (Customer Premises Equipment) para cierta tecnología inalámbrica fija, por ejemplo, WiMAX. Con un CPE situado en el exterior (por ejemplo, en la azotea de una casa), es de esperar que se pueda tener un enlace sin obstrucciones (llamado “línea de vista”) entre emisor y receptor. Además, la antena del receptor puede ser de tamaño relativamente grande, con una ganancia sustancial. En cambio, un AP en el interior recibe una señal atenuada por paredes y otros obstáculos. Lo mismo ocurre con un receptor USB el cual, además, tiene una antena muy pequeña y con una ganancia muy pobre.

| Tipo CPE | Rango de alcance | % cobertura |

|---|---|---|

| Exterior | 20-25 km | 100% |

| Interior | 10.6 km | 53% |

| USB | 2.8 km | 14% |

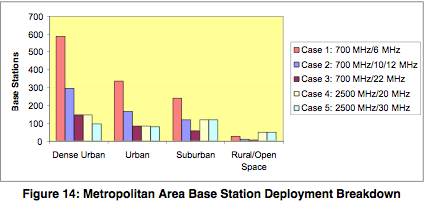

En la figura 6.28 ejemplifica cómo los factores anteriores tienen un impacto profundo al desplegar un sistema de comunicaciones en distintos entornos: En función de la frecuencia, el área de cobertura, el tamaño del bloque y las características del entorno, el número de radiobases requerido para desplegar el sistema varía drásticamente.

Como se explicará más adelante, en una zona urbana densa, no merece la pena tener frecuencias bajas con bloques pequeños, pues el factor determinante es la densidad de usuarios. Una radio base con un bloque pequeño rápidamente se saturará por la demanda de los usuarios, por lo que habrá que desplegar muchas más radio bases, reduciendo su potencia de transmisión para que no se genere interferencia entre ellas. En cambio, en unza zona rural, hay muy pocos usuarios, y se tenderá a privilegiar el uso de frecuencias que cubran la máxima distancia posible.

Figura 6.28: Despliegue de estaciones base en área metropolitana

A continuación se presentan brevemente algunas de las tecnologías de acceso inalámbricas más populares en la actualidad.

Acceso satelital

La idea de tener una estación de relevo para telecomunicaciones (un “espejo”) en el espacio fue propuesta por el científico y escritor Arthur C. Clarke y por Vahid K. Sanadi en los años 40. Unos años más tarde, la Marina de Estados Unidos realizó varias pruebas de concepto en proyectos de espionaje utilizando a la luna, nuestro satélite natural, como espejo para captar las señales emitidas por los radares soviéticos.

El primer satélite artificial lanzado exitosamente fue el satélite ruso Sputnik I, en 1957. No se utilizó para sistemas de telecomunicaciones pero permitió validar la factibilidad técnica de esta tecnología. Un año más tarde la NASA manda fabricar el primer satélite diseñado como relevo de telecomunicaciones dentro del proyecto SCORE.

Los satélites para telecomunicaciones más comunes se encuentran en la llamada “órbita de Clark” en honor a Arthur Clark, a 35,784 km (\(\approx 36,000 km\)) sobre el nivel del mar (snm) en el ecuador. A esa altura, las fuerzas centrífuga y centrípeta están en equilibrio y el satélite tiene la misma velocidad angular que la rotación de la tierra, por lo que parecen “fijos” en el espacio para un observador terrestre. Se les llama satélites geo-estacionarios o GEO (Geo-stationary earth orbit).

Todos los satélites dedicados a difusión de radio y televisión y muchos de los utilizados para acceso a Internet son GEO, pues entre sus ventajas está el hecho de que una vez orientada la antena hacia el satélite, ya no tiene que ajustarse.

Los satélites GEO poseen otras ventajas, como el hecho de que, en principio, con sólo tres satélites se podría cubrir casi toda la superficie terrestre, como se muestra en la figura 6.29 (a).

Los satélties GEO tienen varias limitantes. En primer lugar, es que es muy costoso y complejo colocar un satélite a esa altitud. Además, se requiere de antenas relativamente grandes y de una potencia de transmisión sustancial para que la comunicación pueda llevarse a cabo. Por ello, el uso de satélites GEO para comunicaciones en smartphones, es sencillamente imposible. Por último, la latencia imposibilita comunicaciones bi-direccionales en tiempo real.

Los satélites MEO (Medium-earth Orbit) operan órbitas entre 5,000 y 12,000 km snm. Su diseño es más simple y su puesta en órbita mucho menos costosa. Se utilizan para aplicaciones como monitoreo y fotografiado terrestre, monitoreo atmosférico y para aplicaciones militares.

Se han llegado a utilizar como sistemas de comunicaciones, pero ello implica el uso de antenas especiales que van siguiendo la órbita de un satélite, y del relevo de la comunicación entre algunos de ellos, que forman una constelación.

Figura 6.29: Sistemas satelitales (a) geo-estacionarios y (b) de órbita baja

Los satélites LEO (Low-earth orbit) operan a distancias de 500 a 1,500 km snm. A esa distancia, la latencia es bastante reducida; además, se pueden utilizar antenas de baja potencia (alrededor de 1 Watt). Sin embargo, su cobertura es muy limitada, por lo que se deben desplegar constelaciones de alta densidad (decenas de satélites, como se muestra en la figura 6.29 (b)) y el relevo entre ellos es muy complejo.

Su tiempo de vida es muy corto (5 a 8 años). Si una constelación tiene 50 satélites, se tendría que estar renovando un satélite cada dos meses, lo que hace que estos sistemas tengan un costo de operación muy alto.

Como tecnologías de acceso, los satélites GEO de los años 90 operaban en la banda de frecuencias “C” (4 a 6 GHz) con anchos de banda de 36 a 72 MHz y ofrecían velocidades de acceso de 128 kbps a 2 Mbps.

En la última década se ha hecho popular el uso de la banda Ku (11 a 14 GHz) con anchos de banda más granades. Junto con sofisticadas tecnologías de compresión y codificación, estos satélites permiten velocidades de bajada de cientos de Mbps.

Aunque el servicio de acceso a Internet es sustancialmente más costoso que con las otras tecnologías de acceso, los satélites artificiales garantizan conectividad en zonas donde ninguna otra tecnología es factible, como en aviones, océanos, montañas o zonas desérticas.

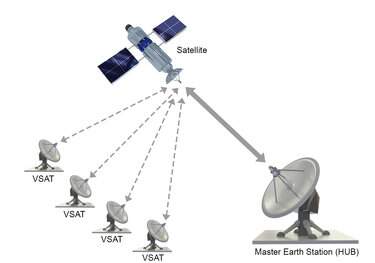

Para reducir los costos de los equipos terminales en enlaces satelitales GEO, se han popularizado los sistemas con antenas VSAT (Very small apperture terminal). En éstos, las antenas de los equipos terminales son comparativamente muy pequeñas (70 cm a 1.5 mt). Dado que estas antenas tienen una ganancia muy baja, la comunicación entre dos usuarios pasa a través de un nodo central (un hub, figura 6.30) con una antena mucho más grande (4 a 10 metros) que permite una gran amplificación de la señal. Desgraciadamente, esto hace que se duplique la latencia, pues el mensaje va del emisor al satélite, de éste al hub, nuevamente al satélite y finalmente al destinatario.

Figura 6.30: Sistema VSAT

A pesar de que la gran mayoría de los proyectos de constelaciones satelitales LEO de los años 90 fueron un gran fracaso comercial, en los últimos 5 años ha resurgido el interés por estos sistemas y empresas como SpaceX, Amazon y OneWeb están invirtiendo miles de millones de dólares para desplegar constelaciones con cientos de satélites intercomunicados entre sí a través de enlaces láser.

HAP (High Altitude Platform)

Las estaciones HAP consisten en vehículos típicamente no tripulados a una altitud de 20 a 50 km en un punto específico relativo a la tierra. Tienen muchos usos en aplicaciones militares y de monitoreo remoto. Para telecomunicaciones, se trata de estaciones de relevo que ofrecen una excelente alternativas para regiones donde no hay servicio terrestre o satelital. También pueden ser desplegados rápidamente para dar cobertura en áreas que han sido afectadas por desastres naturales.

Las tecnologías HAP se empezaron a probar a principios de los años 90, principalmente para aplicaciones militares. A finales de los años 90 el interés por estas tecnologías fue tal, que la Unión Internacional de Telecomunicaciones asignó bandas de frecuencia específicas para servicios HAP: 2 GHz en la banda 47/48 GHz y 6 GHz en la banda 27/31 GHz.

Potencialmente, las HAP ofrecen muchas ventajas: Mayor cobertura y menor tiempo de despliegue que un sistema basado en radio-bases, y por supuesto, con menor interferencia. Con relación a los sistemas satelitales, su costo es mucho menor así como la latencia. Además, se pueden regresar fácilmente a tierra para su reparación y actualización.

Por estas razones, se esperaba que las HAP fueran una atractiva alternativa para tecnologías de acceso a Internet. En la década pasada, hubo muchos proyectos para evaluar su factibilidad en Japón, Corea del Sur, Brasil, la Unión Europea y Estados Unidos. Sin embargo, de las decenas de proyectos documentados, sólo continuaron tres: Los proyectos LOON de Google (actualmente en suspensión), Aquila de Facebook (que se ha aliado con Airbus) y Zephyr de Airbus (figura 6.31).

Figura 6.31: Plataforma no tripulada Zephyr de Airbus

Algunas de las razones por las que estas tecnologías no han sido desplegadas son el hecho de que, a pesar de que tienen un costo sustancialmente menor que los satélites, los componentes de los HAPs son sofisticados, pues deben soportar condiciones de operación muy adversas y tener una alta tolerancia a fallos. En zonas urbanas otras alternativas de acceso son más atractivas y en zonas aisladas, el modelo de negocio los hace inviables.

Por otra parte, varias de las pruebas de concepto se cancelaron por fallos en los vehículos no tripulados, lo que representa un serio riesgo de seguridad en zonas pobladas.

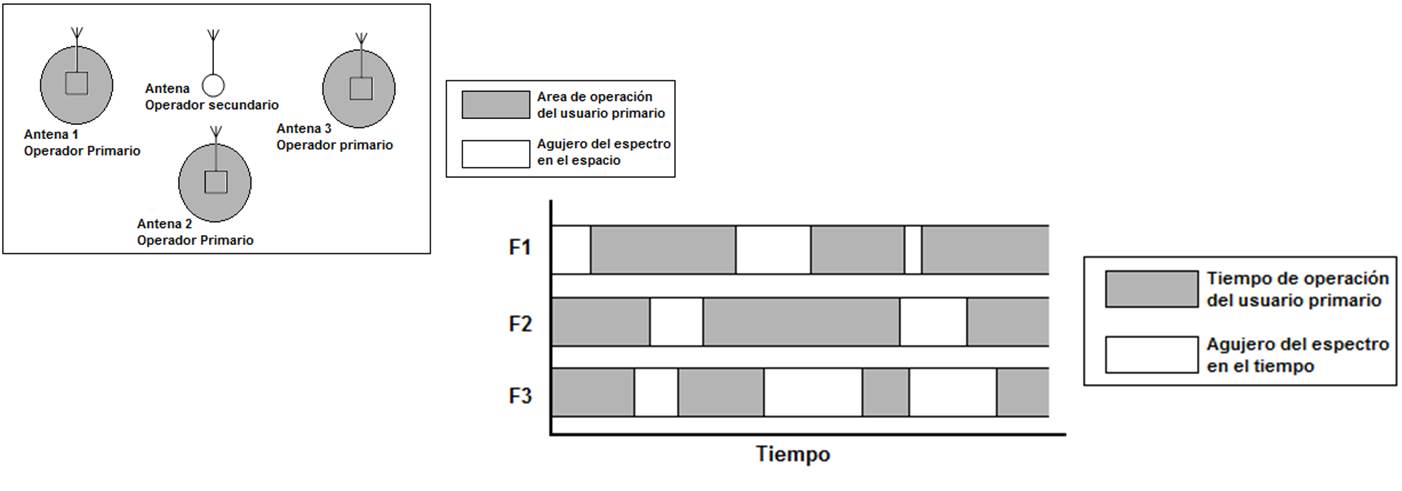

Radios cognitivos

Tradicionalmente se ha considerado que el espectro radioeléctrico es un recurso escaso que debe ser regulado. La forma en que esto suele hacerse, es concesionando bloques de espectro para usos específicos. Por ejemplo, el rango de frecuencias de 87.5 MHz a 108 MHz, está contemplado para concesionarios de radiodifusión en FM, mientras que la banda de 1.9 GHz es una de las frecuencias utilizadas por concesionarios de telefonía celular.

Sin enmbargo, el espectro es un recurso particular pues no se desgasta con su uso. Además, mientras las frecuencias para unos servicios pueden estar saturadas (por ejemplo, telefonía celular) otras bandas pueden estar seriamente subutilizadas (por ejemplo, bandas para radio aficionados, difusión de TV en ultra alta frecuencia y frecuencias para uso militar).

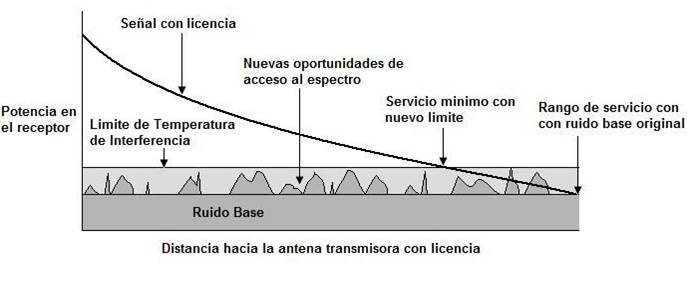

Con el fin de aprovechar mejor el espectro y dejar atrás la percepción de que se trata de un “recurso escaso”, nace la idea de utilizar radios cognitivos (CR, cognitive radio). Se trata de dispositivos que pueden ser configurados dinámicamente para utilizar las bandas de frecuencia disponibles en su entorno y si se detecta que éstas empiezan a ser utilizadas (por otros CR o por los concesionarios de la banda), el radio puede brincar a otras frecuencias libres. De esta manera, se consigue lo que se conoce como gestión dinámica del espectro.

Las primeras propuestas de CR eran un subconjunto de los “radios definidos por software”. El dispositivo sensa su entorno; si encuentra una banda que aparentemente esté libre, calcula cuánta energía generaría su transmisión y si ésta no rebasa un umbral llamado “temperatura de interferencia” (figura 6.32), transmite en esa banda; de lo contrario, busca otro canal.

Figura 6.32: Temperatura de interferencia

Se ha encontrado que es sumamente complicado implementar dispositivos basados en la idea de sensar el entorno y calcular la temperatura de interferencia para establecer una red de comunicaciones confiable. Se requiere de nuevos protocolos y algoritmos para estimar de manera confiable qué bandas podrían ser utilizadas sin generar interferencia.

Una alternativa, surgida en el Reino Unido y ampliamente aceptada, sobre todo para aprovechar los bloques de espectro asignados a difusión de televisión abierta, es la conocida como “espacios blancos” (white spaces). La idea básica es que el regulador sabe qué frecuencias ha asignado en qué regiones, y por lo tanto, cuáles quedan libres en esa región (figura 6.33). El dispositivo tiene un módulo de geolocalización y cuando desea establecer una comunicación, determina su ubicación, consulta la base de datos del regulador y se auto-configura para utilizar alguana de las bandas que están libres en su entorno.

Figura 6.33: Radio cognitivo

El grupo de trabajo IEEE 802.22 ha definido estándares para desplegar redes de área regional (hasta 100 km con baja densidad de población) con base en la tecnología de radios cognitivos con espacios blancos. En Estados Unidos, la base de datos del órgano regulador que consultan estos radios es administrada por Google.

La IEEE también ha definido el estándar IEEE 802.11af para desplegar redes locales inalámbricas con tecnología de espacios blancos. Se le conoce como White-Fi o Super Wi-Fi.

6.3.1 Telefonía celular

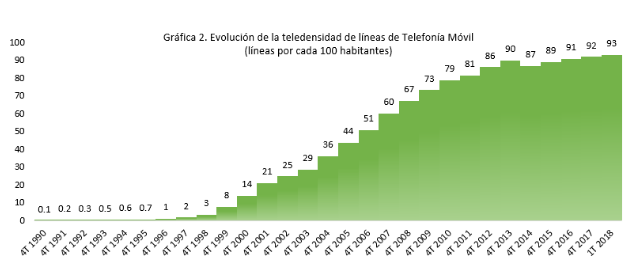

Como se ha mostrado al inicio de este capítulo, la penetración de Internet con tecnologías inalámbricas ha tenido un crecimiento exponencial en todo el planeta. El principal medio de acceso inalámbrico a Internet es la telefonía celular o móvil. En México, el crecimiento de líneas móviles por cada 100 habitantes ha rebasado el 90% como se muestra en la figura 6.34. La penetración de la telefonía móvil ha sido tal que en algunos países ha logrado desplazar hasta el 50% de las líneas de telefonía fija.

Figura 6.34: Evolución de la teledensidad de líneas de telefonía móvil en México

Como se muestra en la tabla 6.1, desde la segunda generación de telefonía celular se han contemplado tecnologías para facilitar la transferencia de datos en las redes móviles, y, eventualmente, proveer acceso a Internet.

| Generación | Tecnología | Velocidad.típica |

|---|---|---|

| GSM | 14.4 kbps | |

| 2G | HSCSD | 36.6 kbps |

| PDC; CDMA | 64 kbps | |

| 2.5G | GPRS | 115 kbps |

| 2.75G | EDGE | 384 kbps |

| 3G | UMTS | 2 Mbps |

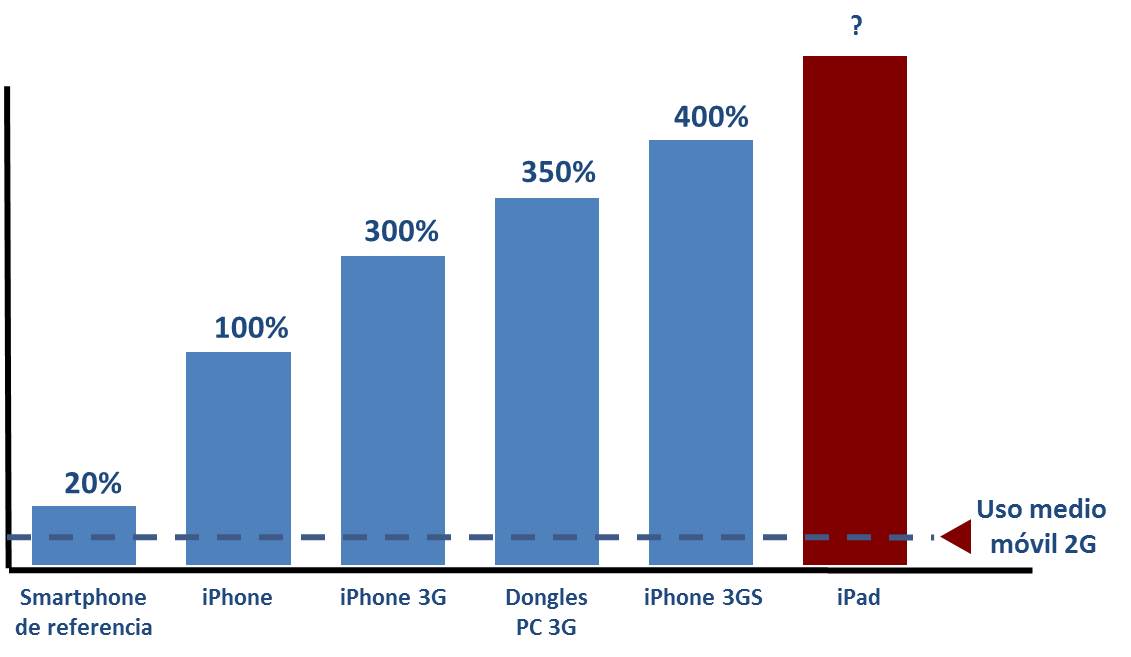

Figura 6.35: Aumento de demanda de tasas de transferencia

Las primeras generaciones de telefonía celular respondían razonablemente bien a las necesidades de teléfonos con pantallas sumamente pequeñas y capacidad de procesamiento muy limitada. Con la llegada de los teléfonos inteligentes, y en especial con la introducción de la familia de dispositivos móviles de Apple, el panorama cambió radicalmente, como se muestra en la figura 6.35.

Estos dispositivos en los que toda la superficie es una pantalla, basados en el uso de aplicaciones móviles (Apps) y que requieren de conexión constante (a veces, continua) a Internet rebasaron por mucho las capacidades de las redes celulares.

Ello llevó a los fabricantes y operadores a acelerar sus hojas de ruta y se dio un rápido despliegue de subgeneraciones (3.5G, 3.75G) que ofrecían mayores velocidades de transferencia, hasta llegar a las actuales redes 4G (LTE, Long Term Evolution) cuya principal característica es que son redes basadas en los principios de transferencia de datos (conmutación de paquetes), en las que la telefonía es un servicio más.

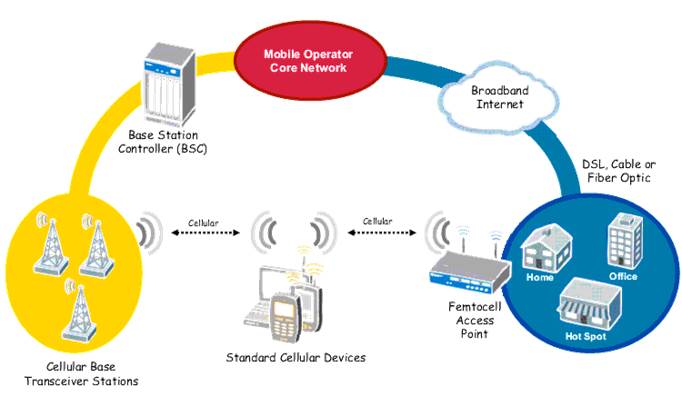

Para zonas donde las redes celulares están altamente congestionadas o la cobertura al interior de edificios es un problema, se han implementado alternativas ingeniosas que complementan el acceso a Internet a través de teléfonos inteligentes. Dos de ellas son las femto celdas y UMA que aparecen en la figura 6.36.

Figura 6.36: Alternativas pra desfogar carga en redes celulares: (a) Femto celdas; (b) Unlicensed Mobile Access

FemtoCeldas

Se trata de una pequeña estación base que proporciona tecnología celular dentro del hogar o la oficina. Se enlaza a la red del operador a través de cualquier tecnología de acceso disponible (típicamente una tecnología alambrada, como FTTH o ADSL). En esa red se establece una VPN con los equipos del operador para fines de administración, tarificación, etcétera.

Los puntos de acceso utilizan las mismas frecuencias que las macro celdas, pero operan a una potencia mucho menor para evitar interferencia. Algunas femto celdas permiten el relevo con las macro celdas (handover) sin perder la conexión, exactamente como ocurre con la itinerancia entre radio bases.

Con técnicas similares a las empleadas para planear el despliegue de redes WiFi, se eligen los puntos óptimos para la instalación de estos puntos de acceso, lo que permite incrementar la capacidad a bajo costo y mejorar la cobertura en interiores.

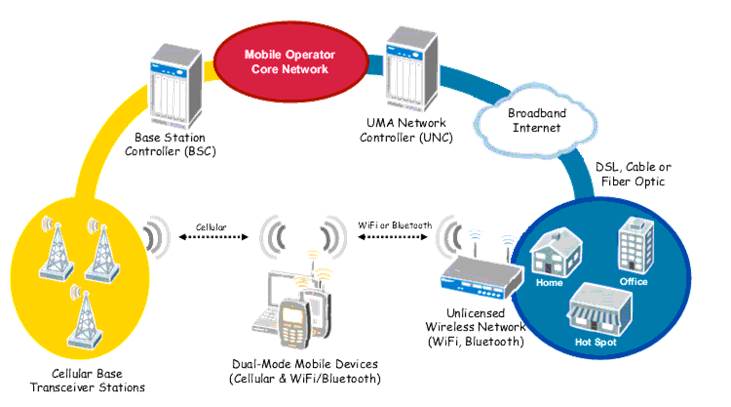

Unlicensed Mobile Access

Es el nombre comercial de una tecnología llamada Generic Access Network (GAN). También se le llama Wi-Fi Calling, VoWiFi.

Dado que prácticamente todos los teléfonos móviles en la actualidad cuentan con la posibilidad de conectarse a redes WiFi, esta tecnología permite que los usuarios utilicen los recursos de la red local cuando se encuentren dentro de su cobertura para acceder a Internet pero también para establecer llamadas telefónicas. Si el usuario sale del área de cobertura de la red WiFi, la red celular se ocupará de hcer la transición a la radio base de manera transparente.

La principal diferencia entre las femto celdas y UMA/GAN, es que en este último caso, el relevo se hace transitando de una pila de protocolos (WiFi) a otra (GSM, UMTS, LTE) además de la transición del AP a la radio base. A esto se le conoce como “relevo vertical” (vertical handover) y requiere de dispositivos móviles que cuenten con esta funcionalidad.

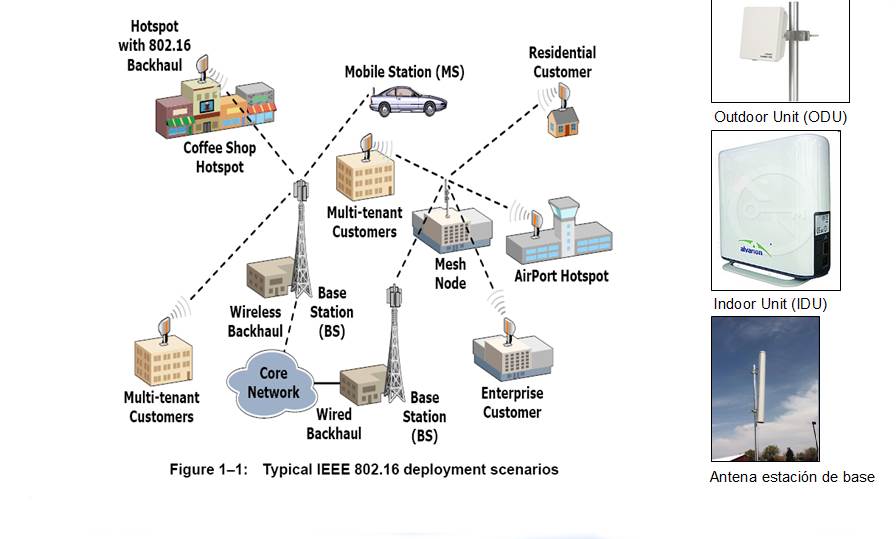

WiMAX - IEEE 802.16

Worldwide Ineroperability for Microwave Access es una norma de transmisión de datos que pertenece a las tecnologías de última milla, utiliza las ondas radioeléctricas en las frecuencias 2,5 a 5,8 GHz y puede llegar a proveer una cobertura de hasta 70 km. En las implementaciones para cobertura móvil, WiMAX permite que los usuarios se desplacen de manera similar que en las redes móviles convencionales (UMTS). También, las características de WiMAX lo hacen adecuado para aplicaciones potenciales como acceso a Internet, backhaul o triple play. Una de sus mayores ventajas es que permite proveer servicios de banda ancha a zonas con baja densidad poblacional que presentan altos costos por usuario. Una de las últimas implenetaciones de WiMAX (WiMAX2-IEEE 802.16m) tiene como objetivo alcanzar una velocidad de descarga de 100 Mbit/s, esto la da potencial para el despliegue de tecnologías de cuarta generación.

Figura 6.37: Esquema de comunicación WiMAX

6.4 Problemas

Problema 6.1 Además de ADSL, identifique otras tres tecnologías de acceso, resaltando su principal ventaja y grado de madurez en México

Problema 6.2 ¿Por qué en un sistema de VSAT se debe recorrer el segmento terrestre-satélite 4 veces?

Problema 6.3 ¿Aproximadamente cuál es la latencia de fuente a destino para una comunicación en los globos de Google? (Tip: un globo vuela más o menos a la altura de un HAP)

- \(\approx 60 \mu\,s\)

- \(\approx 130 \mu\,s\)

- \(\approx 120 ms\)

- \(\approx 240 ms\)

Problema 6.4 El perfil de Don Lencho en Internet es principalmente el de un consumidor de contenidos: Ve regularmente series y películas de Netflix y algunos videos de youtube. En su localidad, solo tiene dos opciones: Contratar un enlace ADSL de 5 Mbps con una renta mensual de $500.00, o un FTTH de 10 Mbps con una renta mensual de $800.00.

¿Qué le recomendarías? Justifica muy brevemente tu respuesta

Agradecemos la colaboración de Rodrigo Calderón Serafín y Diego Gutiérrez Romero para actualizar este material.↩︎

En este curso no ahondaremos en las tasas de penetración y las inequidades de cobertura de Internet en México, pero debemos tenerlo presente.↩︎

El costo del dólar llevado a Paridad de Poder Adquisitivo (Parity Purchasing Power) para eliminar las diferencias entre el valor de las distintas economías.↩︎

1 zettabyte = \(10^{21}\) bytes↩︎

CPE, Customer Premises Equipment, se trata del modem que instala el operador↩︎

Desagregación del bucle local, o del par trenzado, se refiere a un lineamiento que permite que distintos operadores puedan ofrecer sus propios servicios (voz, datos, video) por el par trenzado a pesar de no haber sido ellos quienes lo desplegaron.↩︎